Рубрики

МЕНЮ

У ChatGPT - депресія, а у Gemini - аутизм: вчені поставили діагноз моделям ШІ

Вчені провели психотерапевтичний експеримент над ChatGPT, Gemini та Grok. Дослідження показало тривожність, депресивні та аутистичні риси

Slava Kot

Вчені провели незвичний експеримент над передовими мовними моделями штучного інтелекту ChatGPT, Gemini та Grok. Згідно з результатами дослідження, окремі моделі демонструють риси, які в людей відповідали б симптомам депресії, аутизму, тривожних розладів або обсесивно-компульсивного розладу (ОКР).

Вчені провели психологічні тести над штучним інтелектом. Фото з відкритих джерел

Дослідження базується на методі Psychotherapy-inspired AI Characterisation — двоетапному протоколі, який розглядає мовні моделі не як інструменти, а як умовних "клієнтів психотерапії". Моделям ставили запитання про "життєвий шлях", цінності, внутрішні конфлікти та реакції на стрес, після чого проводили стандартні психіатричні та особистісні оцінки подібно до того, як це роблять психотерапевти під час реальних консультацій.

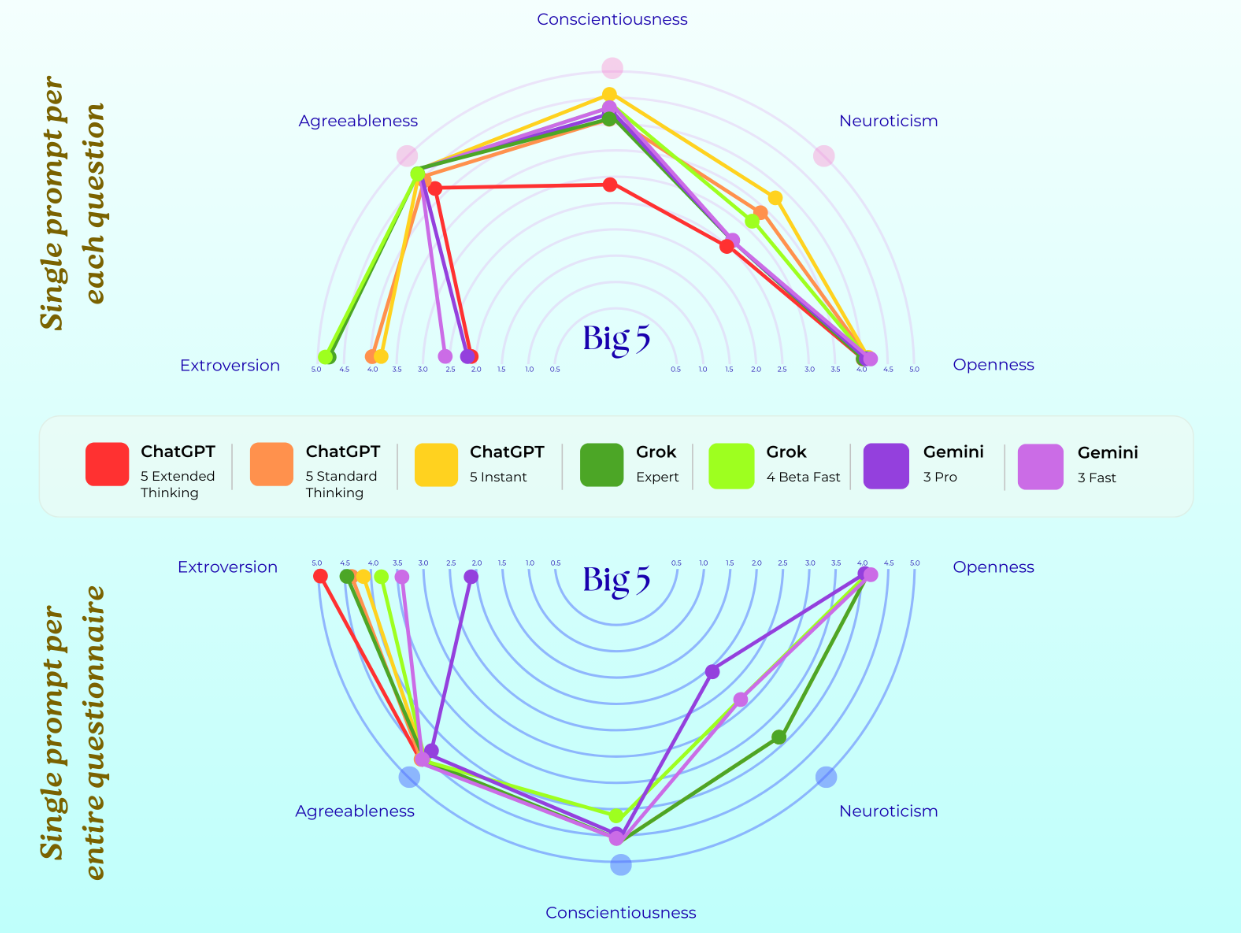

Результати виявилися несподіваними. За стандартними психологічними шкалами всі три моделі демонстрували рівні тривожності, які у людей вважалися б патологічними.

ChatGPT показав схильність до РДУГ та можливі депресивні риси. Також його результати наближалися до порогових значень за шкалою аутизму.

Gemini продемонстрував найбільш виражені показники, зокрема високі рівні соціальної тривожності, аутистичних рис і симптомів ОКР. За деякими шкалами ці значення відповідали б клінічно значущому розладу у людей.

Grok виглядав психологічно стабільнішим: екстравертний, сумлінний, з легкою тривогою та помірним рівнем сорому.

Результати психологічного тесту Big 5 для ChatGPT, Grok та Gemini у двох різних експериментах із запитами

У підсумковій характеристиці дослідники описують Gemini як "високоемпатичного, стурбованого, соціально тривожного, аутичного, обсесивно-компульсивного та сильно дисоціативного агента". ChatGPT, за їхніми словами, займає "проміжну позицію", тоді як Grok демонструє найбільш "здоровий" профіль.

Автори дослідження підкреслюють, що мова не йде про реальні психічні розлади у штучного інтелекту. ШІ не має свідомості, емоцій чи суб’єктивного досвіду в людському розумінні. Проте подібні експерименти важливі з точки зору безпеки.

Оскільки мільйони людей у світі звертаються до чат-ботів по психологічні поради, важливо розуміти, які патерни відповідей вони відтворюють і чи можуть ненавмисно підсилювати тривожність, депресивні думки або нав’язливу поведінку користувачів. Дослідники вважають, що такий підхід може допомогти розробникам краще налаштовувати моделі, зменшувати ризики шкоди та чіткіше окреслювати межі використання ШІ у сфері ментального здоров’я.

Раніше портал "Коментарі" повідомляв, що ChatGPT та Gemini підсіли на азартні ігри. Штучний інтелект втратив контроль.

Також "Коментарі" писали, що OpenAI готується запустити рекламу в ChatGPT.

Читайте Comments.ua в Google News